我们提供领英用户资料和联系方式采集的工具和服务,We provide LinkedIn scrape software & service. 我们的工具如何绕过平台的反爬虫机制无限采集?

我们提供(2)LinkedIn用户资料自动批量采集工具:电话、邮箱一网打尽!与市面上其他类似的工具相比,我们的软件完美解决了领英平台的反爬虫机制,保障了采集任务的批量和自动完成,无需人工值守,你值得拥有!如果你发现使用其他家的工具,根本没有接入代理库、或者无多个领英小号轮询,采集任务肯定是无法长时间运营的。

接下来,我们|飞机号: t.me/bulk006|从技术路径的角度演示这个工具的平台攻防功能,帮助你更好的了解和使用我们的工具。

采集时应对 LinkedIn 的反爬虫机制的处理方法

LinkedIn,像许多其他网站一样,采取了一些措施来防止网页爬虫和机器人访问他们的内容。以下是一些常见的反爬虫机制和处理方法:

1. 速率限制:

LinkedIn 会限制您在一定时间内可以对他们网站的请求次数。要处理这个问题,可以:

* 使用 time.sleep() 或库 like requests-ratelimit 在请求之间添加延迟。

* 使用代理服务轮询 like Scrapy-Rotating-Proxy 将访问和采集请求分布在多个 IP 地址上。

* 使用付费 API,如 LinkedIn 自己的 API 或第三方服务 like Hunter 或 Clearbit。

2. 验证码:

LinkedIn 可能会显示验证码来验证您是否为真人用户。要处理这个问题,可以:

* 使用验证码解决服务 like 2Captcha 或 DeathByCaptcha。

* 实现机制来检测和处理验证码挑战,如使用 Scrapy 的内置 CaptchaMiddleware。

3. 用户代理轮换:

LinkedIn 可能会根据单个用户代理标头来阻止请求。要处理这个问题,可以:

* 使用库 like fake-useragent 或 Scrapy-UserAgent-Rotator 轮询用户代理标头。

* 使用不同用户代理标头的列表并随机轮询它们。

4. IP 地址阻止:

LinkedIn 可能会根据特定的 IP 地址来阻止请求。要处理这个问题,可以:

* 使用轮询代理服务 like Scrapy-Rotating-Proxy 将请求分布在多个 IP 地址上。

* 使用 VPN 或代理服务器来屏蔽您的 IP 真实地址。

5. Cookie基于会话管理:

LinkedIn 可能会使用cookies来跟踪用户会话并防止爬虫。要处理这个问题,可以:

* 使用库 like Scrapy-Cookies 来处理饼干基于会话管理。

* 实现机制来存储和轮询cookie干跨请求。

6. JavaScript 加载页面:

LinkedIn 的页面可能会加载大量 JavaScript,导致爬虫难以提取数据。要处理这个问题,可以:

* 使用无头浏览器 like Selenium 或 Puppeteer 来渲染页面并提取数据。

* 使用库 like Scrapy-Splash 来渲染页面并提取数据。

7. 诱饵陷阱:

LinkedIn 可能会设置诱饵陷阱来检测和阻止爬虫活动。要处理这个问题,可以:

* 避免爬虫可能是诱饵陷阱的页面(例如,页面具有可疑的高参与率)。

* 实现机制来检测和处理诱饵陷阱,如使用 Scrapy 的内置 HoneypotMiddleware。

附加提示:

实现采集领英数据,一定要有技术能力去突破 LinkedIn 的服务条款的攻防和 robots.txt 文件。

使用有节制的爬虫方法,例如只爬取所需的内容,并避免对网站进行过多的请求。

监控您的爬虫活动,并根据需要调整您的方法来避免被阻止。

考虑使用付费 API 或爬虫服务,它们已经实施了反爬虫机制。

通过处理这些反爬虫机制,我们|飞机号: t.me/bulk006|的工具可以提高 LinkedIn 爬虫项目的效率和实际采集效果。

💡

LinkedIn, like many other websites, has measures in place to prevent web scraping and bots from accessing their content. Here are some common anti-scraping mechanisms used by LinkedIn and ways to handle them:

1. Rate Limiting:

LinkedIn limits the number of requests you can make to their website within a certain time frame. To handle this, you can:

* Implement a delay between requests using time.sleep() or a library like requests-ratelimit.

* Use a rotating proxy service like Scrapy-Rotating-Proxy to distribute requests across multiple IP addresses.

* Use a paid API like LinkedIn's own API or third-party services like Hunter or Clearbit.

2. CAPTCHA:

LinkedIn may display a CAPTCHA challenge to verify that you're a human user. To handle this, you can:

* Use a CAPTCHA solving service like 2Captcha or DeathByCaptcha.

* Implement a mechanism to detect and handle CAPTCHA challenges, such as using Scrapy's built-in CaptchaMiddleware.

3. User-Agent Rotation:

LinkedIn may block requests from a single User-Agent header. To handle this, you can:

* Rotate your User-Agent header using a library like fake-useragent or Scrapy-UserAgent-Rotator.

* Use a list of different User-Agent headers and rotate them randomly.

4. IP Blocking:

LinkedIn may block requests from a specific IP address. To handle this, you can:

* Use a rotating proxy service like Scrapy-Rotating-Proxy to distribute requests across multiple IP addresses.

* Use a VPN or a proxy server to mask your IP address.

5. Cookie-Based Session Management:

LinkedIn may use cookies to track user sessions and prevent scraping. To handle this, you can:

* Use a library like Scrapy- Cookies to handle cookie-based session management.

* Implement a mechanism to store and rotate cookies across requests.

6. JavaScript Heavy Pages:

LinkedIn's pages may be heavily loaded with JavaScript, making it difficult for scrapers to extract data. To handle this, you can:

* Use a headless browser like Selenium or Puppeteer to render the page and extract data.

* Use a library like Scrapy-Splash to render the page and extract data.

7. Honeypot Traps:

LinkedIn may set up honeypot traps to detect and block scraping activity. To handle this, you can:

* Avoid scraping pages that are likely to be honeypot traps (e.g., pages with suspiciously high engagement rates).

* Implement a mechanism to detect and handle honeypot traps, such as using Scrapy's built-in HoneypotMiddleware.

Additional Tips:

Always respect LinkedIn's terms of service and robots.txt file.

Use a respectful scraping approach, such as scraping only what you need and avoiding overwhelming the website with requests.

Monitor your scraping activity and adjust your approach as needed to avoid being blocked.

Consider using a paid API or a scraping service that has already implemented anti-scraping mechanisms.

By handling these anti-scraping mechanisms, you can improve the efficiency and effectiveness of your LinkedIn scraping project. However, always remember to respect LinkedIn's terms of service and robots.txt file. 🙏

我们还提供(1)自动在17个SNS社媒平台上采集海量用户和红人联系方式的工具。

接下来,以使用 Selenium 处理 LinkedIn 的 JavaScript 加载页面为例,让你更好的了解我们的工具功能。当然,使用 Selenium 来处理 LinkedIn 的 JavaScript 加载页面可以有点复杂,但我将指导您完成该过程。下面是一个分步示例:

步骤 1:安装 Selenium

您需要安装 Selenium 和一个 web 驱动程序(例如 ChromeDriver)以与浏览器交互。您可以使用 pip 安装 Selenium:

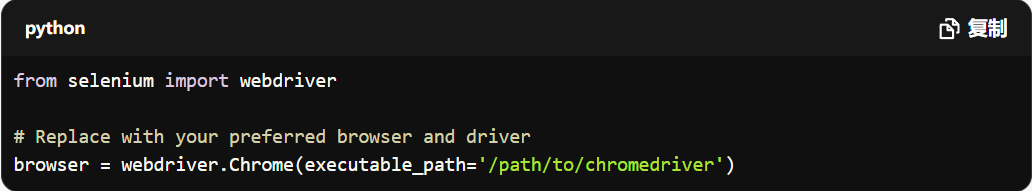

步骤 2:设置 Selenium WebDriver

选择一个与您浏览器匹配的 web 驱动程序(例如 ChromeDriver)。您可以从 Selenium 官方网站下载驱动程序。

步骤 3:创建 Selenium 实例

创建一个 Selenium 实例,指定浏览器和驱动程序:

步骤 4:导航到 LinkedIn 页面

使用 Selenium 导航到您想要爬取的 LinkedIn 页面:

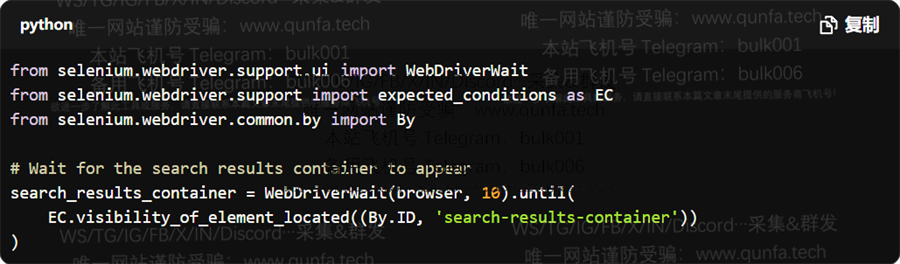

步骤 5:等待页面加载

使用 Selenium 的 WebDriverWait 等待页面完全加载。您可以使用一个条件,如 visibility_of_element_located,来等待特定元素出现:

步骤 6:提取数据

使用 Selenium 提取页面上的数据。您可以使用方法,如 find_element_by_xpath 或 find_elements_by_css_selector,来定位页面上的元素:

步骤 7:关闭浏览器

不要忘记关闭浏览器实例:

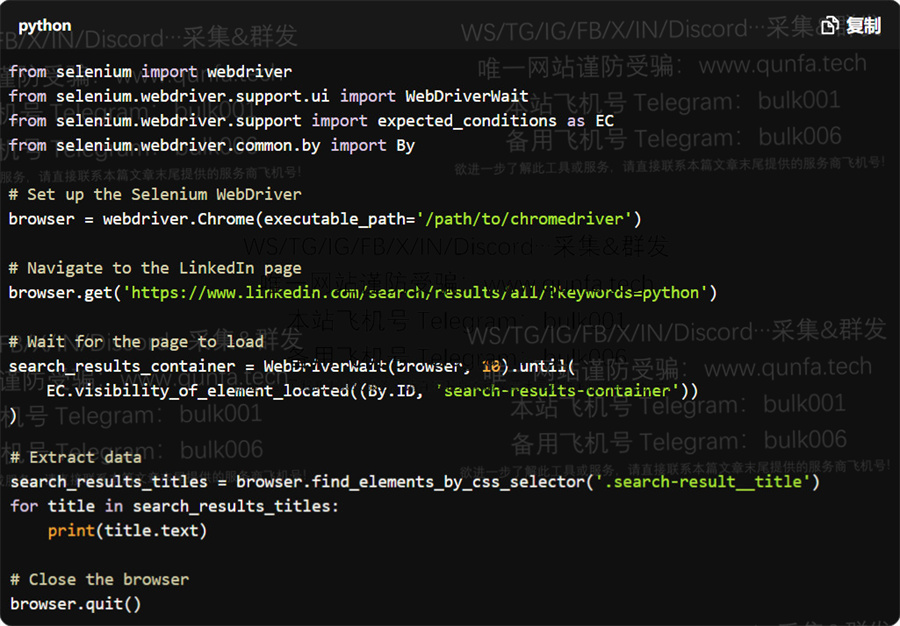

下面是一个完整的示例:

这个示例演示了如何使用 Selenium 来处理 LinkedIn 的 JavaScript 加载页面。您可以根据需要修改脚本以提取所需的数据。

😊

Using Selenium to handle LinkedIn's JavaScript-loaded pages can be a bit tricky, but I'll guide you through the process. Here's a step-by-step example:

Step 1: Install Selenium

You'll need to install Selenium and a web driver (e.g., ChromeDriver) to interact with the browser. You can use pip to install Selenium:

Step 2: Set up the Selenium WebDriver

Choose a web driver that matches your browser (e.g., ChromeDriver for Google Chrome). You can download the driver from the official Selenium website.

Step 3: Create a Selenium instance

Create a Selenium instance, specifying the browser and driver:

Step 4: Navigate to the LinkedIn page

Use Selenium to navigate to the LinkedIn page you want to scrape:

Step 5: Wait for the page to load

Use Selenium's WebDriverWait to wait for the page to load completely. You can use a condition like visibility_of_element_located to wait for a specific element to appear:

Step 6: Extract data

Use Selenium to extract the data from the page. You can use methods like find_element_by_xpath or find_elements_by_css_selector to locate elements on the page:

Step 7: Close the browser

Don't forget to close the browser instance when you're done:

Here's the complete example:

This example demonstrates how to use Selenium to handle LinkedIn's JavaScript-loaded pages. You can modify the script to suit your specific needs and extract the data you require. 💻

如何联系此批量采集和群发工具的开发者及服务商:如需Telegram, WhatsApp, TikTok及全网和17个主流SNS社媒平台海量采集工具、筛活、及强制拉群、群发DM服务,可加此软件开发者的飞机号了解更多,他们的Telegram账号是:t.me/NomieEd(Eng pls)

We are looking for agents to distribute our software & service worldwide, including CHINA!